Mit dem Google Pixel hat Google nun ein neues “eigenes” Telefon an den Markt gebracht und dieses ist als bisher einzige Telefon verzahnt mit dem Google Assistant – sozusagen Google’s Siri oder Google’s Alexa. Der Google Assistant wird Anfang November auch mit Google Home Einzug in die US-amerikanischen Wohnzimmer nehmen.

Nerd wie man nun mal so ist, habe ich also das Google Pixel bestellt und berichte hier über meine Erfahrungen sowohl über das Telefon als auch und umso mehr über den Google Assistant als Konkurrenz zu Amazon’s Alexa.

Ein paar disclaimer vorweg da ich sicherlich, dass ein oder andere “Standard” Android Verhalten anprangern werde. Ich war und bin bis heute ein iPhone Nutzer und hab trotz mehrfacher Versuche mich nie wirklich mit dem Android Betriebssystem anfreunden können.

Das Gerät

So sieht das Pixel aus. Es ist etwas größer als ein iPhone 6s (das mit dem Riss im Display) und es ist flacher. Der erste Eindruck ist ein sehr sehr Positiver. Ein wahrlich gut gelungenes Telefon. Der Fingerabdruck-Sensor ist auf der Rückseite des Geräts, was es im “normalen” Handling sehr angenehm macht. ABER – hat jemals jemand versucht das Pixel im Auto in einer Halterung zu benutzen? Offensichtlich nicht. Man kann das Telefon NICHT blind entsperren – oder handsfree. Das ist eine totale Katastrophe! Als Alternative zum Entsperren, kann man auch einen Aufwärts-Swipe machen und dann entweder ein Muster oder einen PIN eingeben, aber das geht nicht blind während man fährt. Wer sich das ausgedacht hat, fährt wohl nur noch in selbstfahrenden Autos in Mountain View durch die Gegend.

Das Betriebsystem des Pixel fühlt sich deutlich besser und logischer an als jedes Android Gerät, was ich jemals in der Hand hatte (und als mPOS Anbieter hatten wir dutzende Android Test-Geräte). Das Gerät ist super schnell, die vorinstallierten Google Applikationen lassen kaum noch einen Wunsch übrig. Zum Spaß und Test habe ich aber natürlich gleich noch Allo – den neuen Google Messenger mit Google Assistant Integration – heruntergeladen um zu schauen ob und wie nahtlos die Integration funktioniert.

Google Assistant

Der Google Assistant “wohnt” im Telefon selbst, man könnte fast meinen es ist das Herzstück des gesamten Gerätes. Ein wenig Angst und Bange wird einem schon, wenn man bei den Berechtigungen zustimmt, daß der Assistant Texte auf dem Bildschirm und auch Screenshots davon nutzen darf, aber mein Test soll ja zeigen was der Google Assistant unter idealen Bedingungen alles kann.

Der Assistant kann zu jeder Zeit mit dem wake word “Ok, Google” aufgerufen werden. Hinweis für alle Nutzer die Batterie sparen wollen – wenn man den Batterie Sparmodus anmacht dann geht das Wake word nicht mehr – bevor irgendjemand anderes auch noch anfängt das Telefon anzuschreien warum das zum Kuckuck nicht mehr funktioniert (Liebes Google Team SAGT das dem Nutzer auch mal irgendwo!!).

Wie nicht anders von Google zu erwarten ist der Assistant sehr Suche zentriert, d.h. wenn der Assistant irgendetwas nicht findet, dann zeigt er die Suchergebnisse der Anfrage an.

Was kann man nun also alles mit dem Google Assistant machen? Erinnerungen, Events, Timer, Alarme, Navigation, Suchen, Faktensuche, News, Textnachrichten schicken, Anrufe tätigen, sogar eine Whats App integration ist alles schon vorhanden – ABER keine Allo Integration! Really? Wie lustig ist das denn? Ich kann sagen “Ok, Google send a whats app to XYZ “ aber ich kann nicht sagen “Ok, Google send a message to X via Allo”. Hoffen wir mal, dass das fix nachgereicht wird.

Die Spracherkennung ist meistens großartig aber auch mit einzelnen negativ Beispielen.

“Ok, Google text Konstantin Wolff” transkribiert der Assistant zu “Constantine Wolf” und findet den Kontakt nicht. Nach mehreren erfolglosen Versuchen ist der Assistant so nett und sagt dann auch “Give me only a first or last name”, daß er dann allerdings trotz “Wolff” (transkribiert zu “Wolf”) aber Wolfgang findet und nicht Konstantin ist großer Mist.

Hier aber der positive Fall:

“Ok, Google send a message to Paul”

“Paul sure. Which number?” – zeigt Festnetz und Mobil Nummer

“Mobile”

“Whats app or sms?” – wow erstes Aha Erlebnis

“What’s the message?”

“bla bla”

“Got it. Do you want to send or change it?” – und zeigt die Nachricht an

“Send”

Soweit so gut. Nun kommt aber der zweite Versuch:

“Ok, Google send a message to Paul”

“Sure. Whats app to Paul. What’s the message?” – und hat die Mobil Nummer ausgewählt

WOW, es lernt! Das nenne ich mal Fortschritt. Der Dialog verkürzt sich massiv und ich bin bereits im zweiten Versuch deutlich schneller.

Generell fährt der Google Assistant ähnlich wie Apple’s Siri keine Voice First Strategie, sprich das Ergebnis einer Anfrage ist nicht immer eine Sprachantwort (insbesondere Anfragen die zu Suchergebnissen führen, haben nie eine Sprachausgabe), sondern immer auch eine visuelle Darstellung auf dem Smartphone Bildschirm. Manchmal führt das dann sogar zu absurden Situationen wo der visuelle Inhalt der Sprachwiedergabe widerspricht.

“Ok, Google. Do I need an umbrella?”

“No, the forecast for Berlin is cloudy…”

Gleichzeitig zeigt der Bildschirm aber die Wettervorhersage an und zeigt für jetzt eine Regenwahrscheinlichkeit von 40% an – sowas verwirrt Nutzer.

Manchmal ist der Google Assistant auch etwas eigensinnig wie man Anfragen formulieren muss. Diese Utterance Problematik (Utterances sind die hunderte oder tausende von Variationen wie man eine bestimmte Frage stellen kann) kennen viele aus Apple’s Siri was einen ja manchmal partout nicht verstehen will, aber ist jedem Amazon Alexa verwöhnten Voice Nutzer komplett fremd. “Ok Google. Monitor flight EZY 5416” führt zur Anzeige des Suchergebnisses und keiner Sprachausgabe. “Ok Google what’s the flight status for EZY5416” hingegen führt zu der richtigen Sprachausgabe und auch der richtigen Visualisierung. Hier muss Google noch einiges an Arbeit leisten um auf die Natürlichkeit einer Alexa zu kommen. Bei Alexa hat man das Gefühl egal was man sagt sie versteht den Nutzer und genau dieser “Wow”-Moment ist die Faszination bei Voice.

Begeisterung löst aber der Voice everywhere Ansatz des Telefons aus. Egal ob ich irgendwas auf dem Telefon suche, per Google Assistant etwas mache, bei der Google Websuche, bei Whats App Eingabe – überall ist ein Mikrofon Knopf und ich kann super einfach per Spracheingabe alle Eingaben erledigen. Ein sehr schöner use case ist:

“Ok, Google. Navigate Home” – wobei Home hinterlegt wurde als meine Heimat Adresse.

Google Maps erscheint und hat die Route fertig und fängt an zu navigieren.

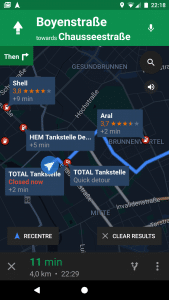

“Ok Google find gas stations on the way”

“There are at least 3 gas stations on the way. The first station is X. Do you want directions, call or say next” – soweit so gut.

“Directions” – Nun passiert aber folgendes:

“Not sure how to help with directions to X”

Ach herrje.

Schade ist auch, dass ich statt den zweiten “Ok Google” Befehl innerhalb von Maps auf das Mikrofon Symbol drücken kann und “find gas station on the way” sage. Das Resultat ist “Showing gas stations on the way” und eine Gesamtansicht der Route mit allen Tankstellen als Markern inkl der Auskunft wie sich die Ankunftszeit verändert. Also etwas vollkommen anderes mit z.T. relevanteren Informationen (und leider auch widersprüchliche Angaben – siehe Total Tankstelle).

Hier sieht man ganz deutlich, daß bisher keine tiefe Integration / Abstimmung mit allen Diensten erfolgt ist, der Google Assistant noch einen weiten Weg vor sich hat und noch nicht eine gute und relevante Sprachwiedergabe für jeden use case vorhanden ist. Keiner möchte als Sprachausgabe “Telefonmenüs” haben (1 für Option A, 2 für Option B), dies widerspricht dem Voice Ansatz komplett. Eine gute Sprachausgabe müsste meines Erachtens auf jeden Fall die Information enthalten um wieviel sich meine Ankunft verlängert. Natürlich sollten die unterschiedlichen Eingabevarianten auch immer zu konsistenten Ausgaben führen.

Ein weiteres Beispiel ist die Inkonsistenz bei der Nutzung der Google anvertrauten persönlichen “Präferenzen”. Offensichtlich kann Google Assistant auf meine hinterlegten Adressen zugreifen (Home, Work, etc). Auf meiner Google Home card (der Bildschirm der beim rechts swipe auf dem Home screen erscheint) habe ich aber z.B. auch meine Lieblingssportvereine hinterlegt. Bei “Ok, Google. Show me the sport news for my teams” erhalte ich als Ergebnis aber Suchergebnisse und mitnichten die aktuellen Ergebnisse des HSV wie auf der home card zu sehen. Allerdings ist die home card da auch noch nicht perfekt, denn sie zeigt keine Ergebnisse der Golden State Warriors (auch als Team hinterlegt) an, obwohl schon die pre-season läuft. Es wird noch eine Weile dauern bis die virtuellen Assistenten so gut sind wie ein menschlicher.

Fazit

In wenigen Worten – ich bin begeistert. Das Google Pixel und der Google Assistant sind eine geniale Kombination und ich bin gewillt bei dieser Kombi zu einem Android Nutzer zu werden. Ja es fehlt noch Feinschliff und ja es gibt einige Sachen die sind noch nicht 100%ig (und ich werde noch einen Weg finden mit Konstantin per Google Assistant zu kommunizieren). Diese Kombination zeigt aber sehr deutlich wie die Zukunft von Voice Assistenten aussehen kann insbesondere wenn man ein so breites Öko-System (Android, Maps, Mail, Suche und demnächst Home) hat wie Google. Der Unterschied zwischen dem Google Assistant und Apple’s Siri ist enorm und ich kann nur hoffen, dass Apple wirklich Siri 2.0 auf dem “Hello again” Event nächste Woche ankündigt. Im Vergleich mit Amazon’s Alexa hat meines Erachtens Amazon noch die Nase vorn was die Erkennung und Natürlichkeit angeht.

Hier soll nicht unterschlagen werden, daß der Ansatz zwischen dem Google Assistant und Amazon’s Alexa sehr unterschiedlich ist. Alexa hat einige wenige use cases die der Assistent dort sehr gut bedient. Durch die unterschiedlichen Skills (“Apps”) in Alexa bleibt der “Sprachraum” für die Spracherkennung aber sehr begrenzt. Während ein Google Assistant versucht “alles” zu verstehen und damit mit einem immensen Sprachraum und diversesten Intents (was will der Nutzer) zurecht kommen muss.

Google hat vieles richtig gemacht und viele Vorteile durch die Integration in ein mobiles Gerät und mit der Suche als “fallback”. Dieses “Ok Google” ist allerdings so sperrig wie irgendwas, da sollte Google doch bitte wie alle anderen Sprachassistenten einen schönen Frauennamen finden.

Ich freue mich auf mein Google Home Anfang November und hoffe, daß ab dann auch eigene Integrationen möglich sind und ich nicht nur “Ok Google find sushi places” sagen kann und eine Übersicht erhalte sondern ich dann auch gleich noch bestellen kann.